Vous avez toujours rêvé d’exploiter le potentiel de l’intelligence artificielle sur votre Raspberry Pi, mais vous ne savez pas par où commencer ? Pas de panique ! Dans cet article, nous allons vous montrer comment exécuter des modèles d’IA localement sur votre appareil, sans avoir besoin de matériel supplémentaire. Préparez-vous à plonger dans le monde fascinant de l’IA sur Raspberry Pi avec notre guide pratique.

Les exigences pour une expérience optimale

Pour débuter, vous aurez besoin d’un Raspberry Pi doté d’au moins 2 Go de RAM, ce qui vous permettra de profiter d’une expérience fluide. Personnellement, j’utilise le Raspberry Pi 4 avec 4 Go de RAM, et il permet d’exécuter des modèles d’IA sans accroc. Il est même possible d’expérimenter avec un Raspberry Pi Zero 2 W, bien que cela puisse être limité par ses 512 Mo de RAM.

Installer Ollama sur votre Raspberry Pi

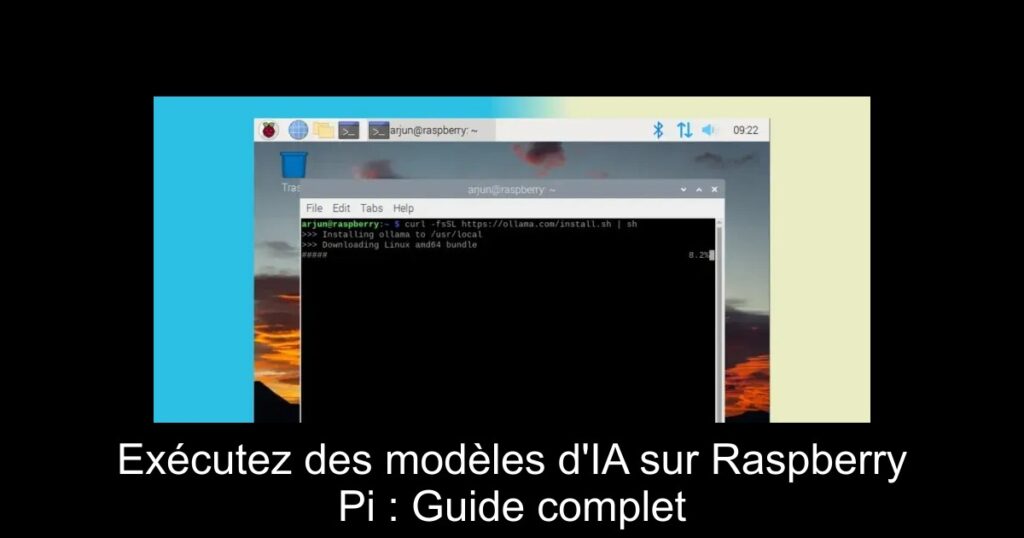

Avant de pouvoir exécuter des modèles d’IA, installez Ollama sur votre Raspberry Pi. Si vous n’avez pas encore configuré votre appareil, assurez-vous de le faire maintenant. Ouvrez le terminal et commencez par mettre à jour vos paquets avec la commande suivante : sudo apt update && sudo apt upgrade. Après cela, pour installer Ollama, exécutez la commande suivante : curl -fsSL https://ollama.com/install.sh | sh. À ce stade, une mise en garde apparaîtra, indiquant qu’Ollama utilisera le CPU pour exécuter les modèles localement.

Exécuter un modèle d’IA localement

Une fois Ollama installé, vous pouvez commencer à exécuter des modèles d’IA. Pour cela, commencez par installer le modèle tinyllama, qui est un modèle de 1,1 milliard de paramètres et utilise à peine 638 Mo de RAM. Exécutez la commande : ollama run tinyllama. Bien que la génération de réponses soit plus lente que sur des machines plus puissantes, ces résultats restent satisfaisants pour des projets de petite envergure.

Essayer d’autres modèles adaptés au Raspberry Pi

Si vous recherchez un modèle léger, je recommande le smollm, qui ne consomme que 92 Mo de RAM et possède 135 millions de paramètres. Pour l’exécuter, utilisez : ollama run smollm:135m. Pour ceux qui disposent d’un Raspberry Pi 5, vous pouvez même tenter d’exécuter le modèle Phi de Microsoft, un modèle de 2,7 milliards de paramètres nécessitant 1,6 Go de RAM avec la commande : ollama run phi.

Conclusion et inspirations futures

En somme, à travers ce processus, vous avez découvert comment exécuter des modèles d’IA sur votre Raspberry Pi. Ollama se distingue par sa simplicité d’utilisation par rapport à d’autres frameworks. Si vous êtes passionné par les projets innovants, sachez que mon Raspberry Pi a aussi été transformé en dongle Android Auto sans fil ! Restez connecté pour d’autres guides captivants et n’hésitez pas à poser vos questions dans les commentaires.