Le monde de l’intelligence artificielle continue d’évoluer de manière fascinante. Meta, l’entreprise mère de Facebook, a récemment annoncé le lancement de ses nouveaux modèles Llama 3.2, qui intègrent des capacités de vision pour la première fois. Cet article explore les détails des nouveaux modèles, leurs applications et ce que cela signifie pour l’avenir de l’IA.

Présentation des modèles Llama 3.2

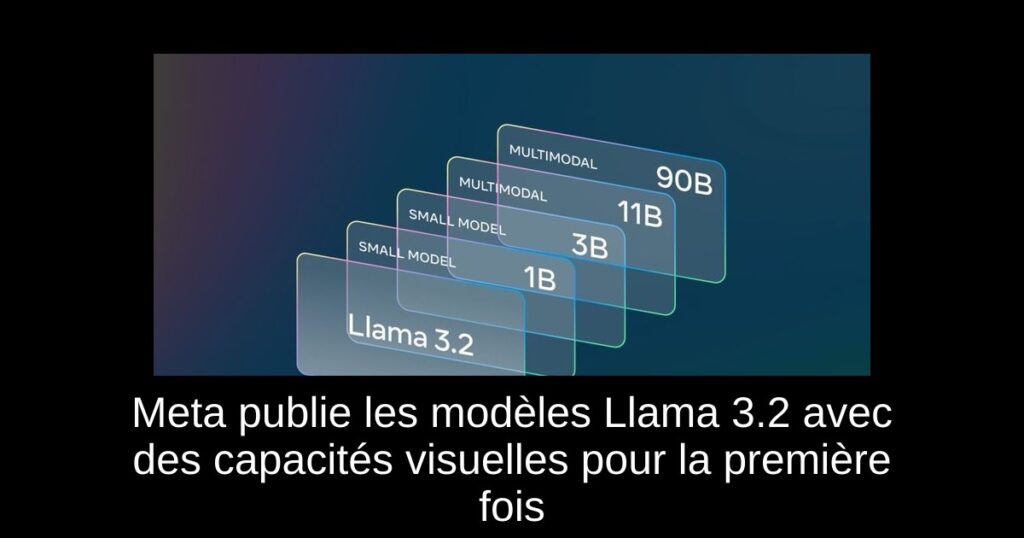

Le 25 septembre 2024, Meta a levé le voile sur la famille de modèles Llama 3.2 lors de l’événement Meta Connect 2024, avec Mark Zuckerberg en tête d’affiche. Cette nouvelle gamme inclut des modèles texte seulement, Llama 3.2 1B et 3B, optimisés pour les tâches sur appareils mobiles et ordinateurs portables. Ces modèles sont conçus pour faciliter des opérations telles que la summarization, le suivi d’instructions, la réécriture, et même l’appel de fonctions pour créer des intentions d’action localement.

En outre, deux modèles plus volumineux, Llama 3.2 11B et 90B, introduisent la multimodalité avec la capacité de traiter des images. Cela offre une nouvelle dimension aux interactions avec l’IA, concurrençant directement les modèles d’OpenAI.

Modèles Llama 3.2 optimisés pour les tâches sur appareils

Les modèles Llama 3.2 1B et 3B sont spécialement conçus pour atteindre des performances optimales sur des appareils tels que les smartphones et les laptops. Ils sont affinés et distillés à partir des modèles plus grands Llama 3.1 8B et 70B. Grâce à cette optimisation, ces petits modèles surpassent les modèles concurrents comme Gemma 2 de Google et Phi-3.5-mini de Microsoft, permettant aux développeurs de les intégrer facilement dans des applications sur les plateformes Qualcomm et MediaTek.

Intéressant à noter, ces modèles permettent une opération locale sans nécessiter une connexion constante à Internet, ce qui est un atout pour de nombreuses applications.

Capacités de vision des modèles Llama 3.2

La vraie innovation vient des modèles de vision Llama 3.2 11B et 90B. Ces modèles plus larges remplacent les anciens modèles texte seulement et sont capables de traitement visuel avancé. Ils peuvent analyser les images et répondre à des questions à leur sujet. Imaginez pouvoir télécharger une image d’une recette, et obtenir des instructions précises sur la façon de la préparer.

Ces modèles ne se limitent pas à des analyses simples. Par exemple, Meta AI peut recréer votre visage dans divers scénarios et portraits, offrant des applications intéressantes dans le monde de l’art numérique et des réseaux sociaux.

Applications étendues et impact sur les utilisateurs

Les modèles de vision discutés prennent également en charge la compréhension des graphiques et des tableaux, ajoutant une couche d’intelligence précieuse pour les utilisateurs d’applications de réseau social comme Instagram et WhatsApp. Ils peuvent générer des légendes automatiquement pour améliorer l’engagement.

Avec cette première sortie de modèles multimodaux sous licence open-source, Meta ouvre également la voie à des développements futurs. Les utilisateurs, les développeurs et les entreprises pourront désormais tester ces modèles dans un cadre compétitif, transformant les interactions avec l’IA.

Conclusion

Le lancement des modèles Llama 3.2 avec capacité de vision marque une étape importante dans le domaine de l’IA. Avec des performances optimisées pour les appareils et une puissance de traitement visuel, Meta positionne ses modèles comme des leaders dans l’industrie. Il sera passionnant de voir comment ces innovations seront adoptées et utilisées à l’avenir.